Étude critique du CREDISCORE utilisé dans la vidéo de Voronej

Avertissement :

Cette étude est la suite d'un précédent article sur la vidéo "VORONEZH, RENCONTRE DU 3e TYPE ou INTOX ?"

Se référer au contexte pédagogique de l'étude d'une phénoménologie OVNI, voir les autres articles qui approfondissent le sujet.

Le vidéaste utilise une carte heuristique pour noter la crédibilité d'un cas ovni et la propose à la communauté pour l'évaluer. Nous allons dans cette courte étude répondre à quelques unes de ses interrogations.

Introduction — Pourquoi cette critique, pour qui, et pour quoi faire ?

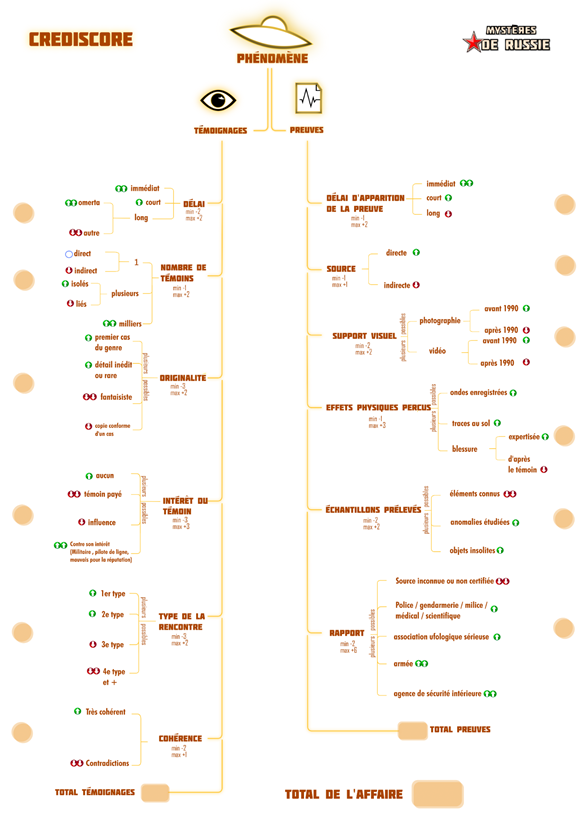

Référence du schéma utilisé — La grille heuristique dite « CREDISCORE » (telle qu’employée par le vidéaste) constitue le cadre d’évaluation étudié dans ce rapport. Pour faciliter la lecture, le schéma original est reproduit ci‑dessous (Figure ) ; il permet d’identifier visuellement les deux piliers (« Témoignages » / « Preuves »), les branches de critères et la logique d’addition en un « Total de l’affaire » mentionnés tout au long de l’Introduction et des Chapitres 1–2.

Pour les procédures opérationnelles détaillées, voir également les Annexes à (fiches et gabarits prêts à l’emploi).

Figure — Schéma « CREDISCORE » (grille heuristique utilisée dans la vidéo)

Dans un paysage informationnel saturé, les affaires dites « extraordinaires » - dont les cas OVNI ne sont qu’un exemple emblématique - se heurtent à une double difficulté : l’incertitude intrinsèque des données (témoignages, images, traces) et la complexité des contextes (sociaux, techniques, médiatiques) dans lesquels elles émergent. Le présent article a un objet simple et concret : examiner de manière critique et pédagogique le CREDISCORE, une grille heuristique de crédibilité, afin d’en montrer l’utilité, d’en délimiter les limites, et de proposer une méthodologie actualisée adaptée à la complexité contemporaine.

Cette critique n’est pas un « procès » de l’outil, mais un levier d’apprentissage partagé. Notre posture est pédagogique : rendre les critères intelligibles au profane, opératoires pour l’expert, et réplicables pour les équipes qui souhaitent comparer des dossiers dans le temps. Nous cherchons à transformer une grille utile en instrument robuste, c’est-à-dire transparent dans ses règles, traçable dans ses décisions et améliorable par itérations.

Une méthodologie pensée pour la complexité

- Biologie de la cognition / énaction : l’outil et l’observateur co-construisent l’objet évalué ; il faut donc rendre visibles les choix de critères et de pondérations.

- Ethnométhodologie / sociologie de la connaissance : les décisions doivent être rendues publiques et justifiées (accountability) afin que d’autres puissent comprendre, critiquer et reproduire l’évaluation.

- Systémique et cybernétique de second ordre : l’évaluateur fait partie du système évalué ; il faut des boucles d’auto-correction (calibration, versionnage, audits) pour limiter les dérives.

- Phénoménologie et épistémologie de la complexité : préserver la texture du réel (contextes, incertitudes, dépendances) tout en produisant des résumés décisionnels lisibles.

À quoi sert cette critique ?

- Aux enquêteurs et analystes : un mode d’emploi opérationnel pour stabiliser les notations, réduire les biais et prioriser les suites d’enquête.

- Aux décideurs et au public : une lecture claire de ce que le score dit (et ne dit pas), avec sa marge d’erreur et ses justifications.

- À la communauté : une base réplicable pour accumuler des cas comparables, améliorer les barèmes et débattre sur des fondements communs.

Ce que nous proposons

- Une mise à plat des forces de la grille (lisibilité, clôture narrative) et de ses faiblesses (barèmes implicites, recouvrements, critères datés).

- Une feuille de route de modernisation : barèmes calculables, fiche d’authenticité des médias, double codage, affichage de l’incertitude, seuils explicites, contrôles anti-doublon, calibration périodique.

- Une double lecture à chaque étape : une version profane (claire, concrète, orientée pratiques) et une version experte (ancrée théoriquement, outillée méthodologiquement).

Comment lire l’article

- Partie 1 présente les principes directeurs et les points critiques du CREDISCORE sous forme de commentaires pédagogiques compacts.

- Partie 2 développe chaque point en double lecture (profane / experte) pour passer du principe à l’action.

- Deux tableaux clôturent cette entrée en matière : Tableau A (problèmes scientifiques et criticité) et Tableau B (concepts et outils pour auditer et améliorer).

Portée et limites

Notre proposition vise la rigueur sans techniciser inutilement. Elle n’épuise pas tous les cas ni toutes les écoles méthodologiques, mais elle offre un socle commun pour discuter, tester, et itérer. Dans cet esprit, nous assumons une réflexivité : chaque amélioration proposée est documentée, testable, et révisable.

Partie 1 — Principes directeurs et points critiques du CREDISCORE

1) Deux piliers additionnés : Témoignages et Preuves

Le CREDISCORE sépare ce que disent les personnes (témoignages) de ce qui peut être vérifié (preuves matérielles, documents, analyses), puis additionne les deux. Cette séparation rend la décision intelligible et évite de confondre récit et vérification. Concrètement, on note d’abord les témoignages, puis les preuves, on affiche les deux sous-scores et seulement ensuite le total. Cela permet d’identifier immédiatement ce qui manque (par exemple, des preuves indépendantes), de limiter les interprétations hâtives et de guider la suite de l’enquête.

2) Cas « extraordinaires » plus exigeants ; traçabilité institutionnelle valorisée

Plus un récit est inhabituel (rencontre rapprochée, effets physiques spectaculaires), plus la barre des preuves doit être haute. Les pièces issues d’institutions identifiables (police, hôpital, armée, laboratoire) ont davantage de poids parce qu’elles sont traçables : on sait qui a fait quoi, quand et comment. On évite ainsi d’accorder trop de crédit à des histoires impressionnantes sans dossier solide. La règle opérationnelle est simple : pas de preuves traçables, pas de classement en « solide ».

3) Le score comme outil de clôture narrative

Le score sert de « panneau de sortie » : il synthétise l’enquête et rend la décision lisible pour tous. Il ne doit jamais être affiché seul : on l’accompagne d’un court encadré qui explique ce qui a le plus pesé, ce qui a limité l’évaluation, les points encore discutés et les actions recommandées. Cette mise en scène finale évite l’illusion d’objectivité d’un chiffre nu et oriente la suite du travail.

4) Barèmes internes : le besoin d’un manuel de codage

Les plages de note (de −2 à +2) n’indiquent pas, à elles seules, quand choisir une valeur plutôt qu’une autre. Sans règles écrites et exemples concrets, deux évaluateurs compétents peuvent aboutir à des notes différentes. Un manuel de codage avec définitions opératoires, cas limites et petits arbres de décision stabilise les pratiques, améliore l’accord entre évaluateurs et rend l’outil plus juste et reproductible.

5) Recouvrements entre rubriques et double comptage

La même information peut, par inadvertance, rapporter des points dans plusieurs rubriques (par exemple « rapport officiel » et « expertise »), gonflant artificiellement le score. Pour l’éviter, on adopte la règle « une pièce = une bonification » avec une priorité unique, et on attribue à chaque artefact un identifiant qui empêche tout doublon. Résultat : un score plus fidèle et plus transparent.

6) Remplacer « avant / après 1990 » par une échelle d’authenticité forensique

L’année d’une photo ou d’une vidéo n’est pas un bon indicateur de fiabilité. Ce qui compte, c’est l’authenticité vérifiable : métadonnées cohérentes, intégrité du fichier, audit indépendant, chaîne de conservation documentée. Une échelle simple à quatre niveaux (de « provenance floue » à « vérifié par un tiers avec traçabilité complète ») modernise la grille et évite les jugements anachroniques.

7) Rendre visible l’incertitude

Un score unique donne une impression trompeuse de précision. Il faut afficher une marge (par exemple « 62 ± 5 ») issue du double codage et, si possible, d’estimations statistiques simples. Indiquer aussi le degré d’accord entre évaluateurs renforce l’honnêteté de la décision. Cette transparence protège contre les malentendus et rend la comparaison des affaires plus fiable.

8) Énaction et réflexivité : le cadre co-construit l’objet

Un instrument n’est jamais neutre : ses catégories et ses poids influencent l’objet évalué. Il est donc essentiel d’expliciter les choix, d’en conserver l’historique et de les ajuster à la lumière des retours d’expérience. Cette réflexivité assumée fait du CREDISCORE un outil apprenant, capable de s’améliorer sans perdre sa cohérence.

9) Ethnométhodologie : rendre publiques les raisons des notes

Chaque note doit être compréhensible par un lecteur externe : règle appliquée, sources consultées, raison de la décision. Un court « journal des décisions » par critère suffit, à condition d’être systématique. La publicité de ces justifications crée la confiance, permet l’audit et la réévaluation indépendante, et ancre l’outil dans une culture de responsabilité.

10) Feuille de route pour fiabiliser et moderniser

Pour passer d’une bonne grille à un instrument robuste : publier des barèmes calculables et illustrés, adopter l’échelle forensique des médias, mesurer l’accord entre évaluateurs et afficher la marge d’erreur, définir des seuils d’interprétation clairs, empêcher le double comptage, et recalibrer régulièrement sur des cas étalons. À la clé : des décisions plus comparables, plus justes et plus cumulatives.

Partie 2 — Développement didactique (double lecture)

1) Deux piliers additionnés : Témoignages + Preuves

- Note profane : On met d’un côté ce que racontent les gens, de l’autre ce qu’on peut vérifier concrètement, et on additionne. Voir les deux sous-scores aide à comprendre d’où vient la force (ou la faiblesse) d’un dossier et à savoir quoi chercher ensuite.

- Note experte : Modèle bi-dimensionnel stabilisé par des critères opératoires et un double codage. On publie systématiquement Témoignages, Preuves et Total, afin d’éviter les compensations abusives et d’améliorer la comparabilité inter-dossiers.

2) Extraordinaire plus exigeant, traçabilité valorisée

- Note profane : Plus le récit est incroyable, plus il doit être soutenu par des preuves solides, datées et attribuées. Sans dossiers traçables, un cas ne peut pas être classé comme « solide ».

- Note experte : Principe d’exigence proportionnelle aux fréquences de base et « portes de décision » non compensatoires : certaines classes exigent un niveau minimal de preuves traçables, indépendamment du total.

3) Le score comme heuristique de clôture

- Note profane : Le score résume l’enquête, mais il doit toujours être accompagné d’une explication courte : ce qui a compté, ce qui manque, et la suite proposée.

- Note experte : Sortie standardisée avec total, intervalle de confiance, déterminants, lacunes et recommandations. Le chiffre oriente la décision collective, mais ne s’y substitue pas.

4) Barèmes internes : écrire le manuel

- Note profane : Pour éviter les notes « au feeling », on documente des règles claires avec des exemples concrets. Deux personnes qui suivent le même manuel aboutissent à des notes proches.

- Note experte : Définitions opératoires, exemples frontières et arbres de décision réduisent la variance inter-codeurs ; on vérifie l’accord sur un pilote, on révise, puis on déploie.

5) Double comptage : éviter de compter deux fois

- Note profane : Une même pièce ne doit valoriser qu’une seule rubrique, sinon le score gonfle à tort. Un identifiant unique par pièce bloque les doublons.

- Note experte : Contrôle d’unicité et logique de priorité par rubrique ; l’hygiène d’agrégation préserve la validité du total et la cohérence des poids effectifs.

6) Remplacer « avant / après 1990 » par une échelle d’authenticité

- Note profane : Ce n’est pas l’âge d’un média qui compte, c’est sa preuve d’authenticité. On classe les images/vidéos du niveau « flou » au niveau « vérifié par audit et traçabilité ».

- Note experte : Évaluation forensique fondée sur métadonnées, intégrité, contexte et audit indépendant ; la datation calendaire est remplacée par une métrique d’authenticité.

7) Rendre visible l’incertitude

- Note profane : Dire « 62 avec une marge de 5 » est plus honnête et plus utile que « 62 ». On comprend qu’il y a une petite zone d’imprécision.

- Note experte : Double codage, re-notation différée et estimation d’un intervalle de confiance. Les seuils de décision s’interprètent avec « Total ± marge », pas avec le total seul.

8) Énaction et réflexivité

- Note profane : L’outil influence le résultat. On explique comment il est construit, on garde l’historique des changements et on ajuste quand on découvre un problème.

- Note experte : Pré-enregistrement des règles, calibrations périodiques et traçabilité des révisions : l’instrument devient apprenant et transparent, au lieu d’être figé et opaque.

9) Ethnométhodologie : rendre les raisons visibles

- Note profane : Pour chaque note, on écrit en quelques lignes « pourquoi » et « d’après quelles pièces ». Cela permet à n’importe qui de comprendre la décision.

- Note experte : Manuel public, « grand livre des décisions », et re-codages à l’aveugle sur échantillon : ces pratiques rendent l’évaluation auditables et reproductibles.

10) Feuille de route opérationnelle

- Note profane : Mode d’emploi écrit, fiche d’authenticité des médias, deux évaluateurs, marge d’erreur, blocage des doublons, seuils clairs, journal des décisions, recalibrage régulier : une routine simple et fiable.

- Note experte : Spécification formelle de la formule et des seuils, dispositifs d’accord inter-codeurs, estimation d’incertitude, anti-double-compte outillé et panel d’étalons ; revue annuelle avec rapport d’impact.

Tableau A — Problématique scientifique du CREDISCORE

Aspect évalué

Constat

Risque / biais

Impact

Pour la robustesse

Criticité

Barèmes non explicités

Plages de note sans règles précises

Variabilité entre évaluateurs, non-reproductibilité

Scores non comparables

Manuel de codage détaillé + barèmes chiffrés

Très haute

Fiabilité entre évaluateurs

Pas d’accord mesuré ni de re-notation

Illusion de précision

Décisions instables

Double codage, coefficient kappa de Cohen ≥ 0,70, re-notation différée

Très haute

Double comptage

Rubriques qui se recouvrent

Gonflement artificiel du score

Surévaluation de certains cas

Règles anti-double-compte + unicité « une pièce = une rubrique »

Haute

Pondérations implicites

Poids non justifiés (ex. Preuves > Témoignages)

Biais normatif caché

Orientation systématique

Justification théorique ou calibration sur cas étalons

Haute

Critère visuel daté

« Avant / après 1990 »

Anachronisme

Faux positifs/négatifs

Échelle d’authenticité forensique (4 niveaux)

Haute

Pénalité cas extraordinaires

Malus fixe non documenté

Conservatisme indifférencié

Sous-notation possible

Portes non compensatoires et seuils modulés

Moyenne–Haute

Indépendance des témoins

Critère peu opérationnel

Contamination des récits

Surévaluation du nombre

Tests d’indépendance (co-présence, graphes relationnels)

Haute

Contradictions

Traitement binaire

Effet couperet

Injustice sur micro-écarts

Graduation (mineure/majeure/récurrente)

Moyenne

Seuils d’interprétation

Absents ou flous

Ambiguïté des verdicts

Lectures divergentes

Classes normalisées (faible / incertain / solide / fort)

Moyenne

Incertitude

Score ponctuel sans fourchette

Opacité

Décisions trop tranchées

Score avec intervalle de confiance ; accord publié

Haute

Calibration & cas étalons

Manquants

Dérive des barèmes

Incohérence dans le temps

Panel d’étalons + ré-étalonnage périodique

Moyenne–Haute

Traçabilité des décisions

Faible

Audit difficile

Confiance limitée

Journal des décisions par critère + pièces référencées

Moyenne

Tableau B — Concepts & outils pour critiquer et améliorer

Concept / outil

Définition brève

Pour auditer / critiquer

Pour améliorer (actions)

Énaction / Autopoïèse

L’observateur et l’instrument co-construisent l’objet évalué

Rendre visibles les choix et versions

Publier les options, apprendre/ajuster les poids

Ethnométhodologie / Accountability

Méthodes et justifications compréhensibles publiquement

Repérer les décisions non justifiées

Manuel + « grand livre » des décisions

Cybernétique de second ordre

L’évaluateur fait partie du système évalué

Détecter dérive et effets de halo

Boucles d’auto-correction (plan–faire–vérifier–agir)

Accord entre évaluateurs (kappa de Cohen)

Mesure l’accord au-delà du hasard

Mesurer la reproductibilité

Double codage ; viser kappa ≥ 0,70

Test–retest

Stabilité des scores dans le temps

Détecter instabilité

Re-notation à délai (par ex. 14 jours)

Cohérence interne (alpha de Cronbach)

Cohérence des items d’une même dimension

Repérer items faibles

Ajuster/supprimer les items problématiques

Chaîne de conservation (« custody »)

Traçabilité des artefacts et de leurs détenteurs

Identifier les ruptures de traçabilité

Formulaires horodatés, scellés, empreintes numériques

Forensique image/son

Authenticité, intégrité et contexte des médias

Éviter les jugements datés

Échelle d’authenticité (4 niveaux) + audits tiers

Analyse multicritères (AHP/MAUT)

Pondération et agrégation structurée de critères

Tester la cohérence des poids

Documenter les poids, faire des analyses de sensibilité

Cadre bayésien

Évidence comme mise à jour de vraisemblance

Éviter le double comptage d’indices

Utiliser des rapports de vraisemblance ou éviter les doublons

Courbe ROC / Seuils

Taux de vrais/faux positifs selon le seuil

Évaluer la pertinence des seuils

Ajuster seuils via panel d’étalons

Graphes relationnels (indépendance)

Cartographie des liens entre témoins

Détecter collusions ou co-présences

Indice d’indépendance et atténuation du barème « nombre »

Rééchantillonnage (bootstrap) / Intervalle de confiance

Quantifie la variabilité des scores

Donner une fourchette au score

Afficher « Total ± intervalle de confiance »

GRADE (hiérarchie de preuve)

Classement des niveaux de preuve

Positionner chaque pièce dans une hiérarchie

Aligner la branche « Preuves » sur ces niveaux

Pré-enregistrement

Protocole décidé avant l’analyse

Réduire les biais « après coup »

Déposer la grille et les règles avant codage

Versionnage (historisation)

Suivi des versions et des changements

Traçabilité complète

Dépôt public des versions, journaux de modifications

Vignettes phénoménologiques

Descriptions denses et contextualisées

Préserver la « texture » qualitative

5–10 lignes explicatives par critère avant la note

Glossaire et acronymes

PDCA : cycle Plan–Do–Check–Act d’amélioration continue.

Bootstrap : rééchantillonnage pour estimer l’incertitude.

ELA : analyse des niveaux d’erreur de recompression (traces d’édition).

PRNU/SPN : empreintes de bruit de capteur pour authentifier une image.

GRADE : hiérarchie de niveaux de preuve.

ROC : outil pour choisir des seuils en arbitrant vrais/faux positifs.

ICC : stabilité test–retest (cible ≥ 0,75).

κ de Cohen : accord inter‑évaluateurs au‑delà du hasard (cible ≥ 0,70).

Cybernétique de second ordre : l’évaluateur fait partie du système ; boucles d’auto‑correction.

Accountability : justifications publiques des méthodes et décisions.

Énaction : co‑construction sujet/monde ; l’outil influence l’objet évalué.

ANNEXE 1 — Fiche d’authenticité forensique des médias (modèle & échelle)

Cette fiche standardise l’évaluation de l’authenticité d’un média (photo, vidéo, audio, document). Elle remplace les critères datés (ex. « avant/après 1990 ») par une métrique d’authenticité vérifiable.

Champ

Valeur / Procédure

ID de la pièce (unique)

[à compléter]

Description / contexte de capture

[à compléter]

Source / origine (lien, personne, dépôt)

[à compléter]

Date/heure (TZ) et lieu (coordonnées)

[à compléter]

Détenteur actuel / responsables successifs

[à compléter]

Format & conteneur (codec, résolution, fréquence)

[à compléter]

Empreintes numériques (SHA-256, MD5)

[à compléter]

Fichier source disponible ? (oui/non)

[à compléter]

Métadonnées EXIF/XMP (appareil, objectif, GPS, horodatage)

[à compléter]

Intégrité (hash initial vs vérif ; altérations détectées)

[à compléter]

Traitements/exports (logiciel, version, paramètres)

[à compléter]

Tests forensiques (ELA/PRNU/Rolling shutter/Deepfake/Audio)

[à compléter]

Cohérence spatio-temporelle (météo, soleil/ombres, étoiles)

[à compléter]

Chaîne de conservation (voir tableau ci-dessous)

[à compléter]

Audit indépendant (organisme, rapport, date)

[à compléter]

Niveau d’authenticité (échelle 1–4)

[à compléter]

Conclusion synthétique & recommandations

[à compléter]

Signatures/visa (évaluateur, superviseur, date)

[à compléter]

Chaîne de conservation (timeline) :

Étape #

Date/heure (TZ)

Acteur (nom/fonction)

Action

Empreinte / référence

1

[à compléter]

[à compléter]

[à compléter]

[à compléter]

2

[à compléter]

[à compléter]

[à compléter]

[à compléter]

3

[à compléter]

[à compléter]

[à compléter]

[à compléter]

4

[à compléter]

[à compléter]

[à compléter]

[à compléter]

5

[à compléter]

[à compléter]

[à compléter]

[à compléter]

Échelle d’authenticité (4 niveaux) :

Niveau

Définition opérationnelle

1 — Non documenté

Provenance floue, fichier non source, métadonnées absentes/incohérentes, aucune vérification d’intégrité.

2 — Documenté partiellement

Provenance identifiable, métadonnées partielles, cohérence spatio-temporelle plausible, aucune vérification indépendante.

3 — Vérifié en interne

Fichier source ou copie certifiée (hash), métadonnées cohérentes, tests forensiques de base passés, chaîne de conservation décrite.

4 — Audité indépendamment

Vérification externe documentée, intégrité confirmée (hash concordant), cohérence spatio-temporelle forte, chaîne de conservation complète et signée.

• Fichier source et empreinte (SHA-256) disponibles

• Métadonnées cohérentes (horodatage, appareil, GPS)

• Cohérence spatio-temporelle vérifiée (météo/ombres/étoiles)

• Tests forensiques réalisés et tracés (ELA/PRNU/etc.)

• Chaîne de conservation documentée et signée

• Audit indépendant réalisé (si nécessaire)

• Niveau d’authenticité attribué et justifié

ANNEXE 2 — Protocole de double codage et estimation de l’incertitude

Cette annexe décrit la procédure standard pour mesurer l’accord entre évaluateurs, estimer une marge d’incertitude sur les scores et stabiliser les décisions.

• 1) Formation & manuel : brève formation commune ; lecture du manuel de codage ; cas d’entraînement « frontières ».

• 2) Codage indépendant : au moins deux évaluateurs notent séparément les critères (Témoignages / Preuves).

• 3) Agrégation provisoire : calcul des sous-scores et du total pour chaque évaluateur.

• 4) Mesure d’accord : κ de Cohen (nominal) ou κ pondéré (ordinal) ; viser κ ≥ 0,70 par critère.

• 5) Arbitrage : discussion des divergences > seuil (ex. |diff| ≥ 2) ; consignation de la décision.

• 6) Test–retest : re-notation différée (ex. J+14) pour estimer la stabilité.

• 7) Intervalle de confiance : estimation par rééchantillonnage (bootstrap) ; afficher « Total ± marge ».

• 8) Règle de décision : franchir un seuil de classe seulement si (Total − marge) ≥ seuil et si l’exigence minimale « Preuves » est satisfaite.

Tableau de suivi (gabarit) :

Dossier

Critère

Note A

Note B

Différence

Arbitrage (finale)

Règle (ref.)

Commentaires

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

• κ de Cohen global et par critère ; cible ≥ 0,70.

• Écart absolu moyen entre évaluateurs ; cible ≤ 0,5 point.

• Marge autour du total via bootstrap (≥ 1000 rééchantillonnages).

• Stabilité test–retest (ICC) ; cible ≥ 0,75.

ANNEXE 3 — Gabarit du « Grand livre des décisions »

Documenter, pour chaque dossier et critère, la raison de la note, les sources, les contre-arguments et la décision d’arbitrage.

ID dossier

Critère (réf.)

Règle (manuel §)

Note

Fourchette

Sources (IDs)

Justification (5–10 lignes)

Contre-arguments

Doutes résiduels

Décision

Actions suivantes

Évaluateur

Date/heure

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

• Rédiger la justification avant la note.

• Citer précisément les pièces (ID, page/horodatage).

• Une pièce → une rubrique (anti-double comptage).

• Consigner désaccords et arbitrage.

• Signer, dater, versionner.

ANNEXE 4 — Fiche détaillée « Chaîne de conservation » (custody)

Documenter de bout en bout la trajectoire d’une pièce pour assurer intégrité, authenticité et traçabilité.

Champ

Valeur / Procédure

ID unique de la pièce

[à compléter]

Type (photo/vidéo/audio/document/prélèvement)

[à compléter]

Description / contexte de collecte

[à compléter]

Localisation initiale (adresse/GPS)

[à compléter]

Collecteur initial (nom/fonction/organisation)

[à compléter]

Date et heure de collecte (TZ)

[à compléter]

Support physique / format de fichier

[à compléter]

Empreinte initiale (SHA-256)

[à compléter]

Conditions de conservation (température, scellés)

[à compléter]

Journal des transferts :

Étape

Date/heure

De

À

Action

Support

Hash (avant/après)

Obs.

1

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

2

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

3

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

4

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

5

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

6

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

7

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

Contrôles d’intégrité périodiques :

Date

Fichier/Support

Hash attendu

Hash mesuré

Résultat

Opérateur

Commentaires

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

Anomalies / incidents :

Date/heure

Type

Description

Impact

Mesures

Responsable

Visa

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

ANNEXE 5 — Guide d’audit forensique image/vidéo (pas-à-pas)

• 1) Acquisition : fichier source ou copie certifiée (hash) ; documenter provenance et chaîne.

• 2) Inventaire technique : conteneur, codec, résolution, fps ; extraire métadonnées (horodatage, appareil, GPS).

• 3) Intégrité : vérifier empreintes ; contrôler écritures ultérieures non tracées.

• 4) Cohérence spatio-temporelle : météo, soleil/ombres, astres, topographie.

• 5) Signatures capteur : ELA (image), PRNU/SPN, rolling shutter (vidéo), artefacts d’insertion.

• 6) Physique apparente : vitesses angulaires, parallaxe, profondeur ; tester explications prosaïques.

• 7) Pipelines d’édition : exports, filtres, stabilisation ; logiciels et versions.

• 8) Détection IA : indices de génération/altération (incohérences reflets/ombres/bokeh/bruit).

• 9) Audit indépendant : solliciter une revue tierce si le cas est sensible.

• 10) Conclusion : assigner un niveau d’authenticité (1–4) et consigner limites/doutes.

Grille de constat :

Test

Résultat

Preuves / Référence

Commentaires

Métadonnées (horodatage/appareil/GPS)

[OK / KO / N.D.]

[capture/mesure/référence]

[à compléter]

Hash (source vs copie)

[OK / KO / N.D.]

[capture/mesure/référence]

[à compléter]

ELA / Artefacts de compression

[OK / KO / N.D.]

[capture/mesure/référence]

[à compléter]

PRNU/SPN (bruit de capteur)

[OK / KO / N.D.]

[capture/mesure/référence]

[à compléter]

Rolling shutter / Motion blur

[OK / KO / N.D.]

[capture/mesure/référence]

[à compléter]

Cohérence ombres/soleil/météo

[OK / KO / N.D.]

[capture/mesure/référence]

[à compléter]

Indices d’IA (visages/textures/miroirs)

[OK / KO / N.D.]

[capture/mesure/référence]

[à compléter]

Concordance scène/topographie

[OK / KO / N.D.]

[capture/mesure/référence]

[à compléter]

Synthèse d’audit :

Critère

Indice clé

Évaluation

Niveau (1–4)

Incertitudes

Intégrité du fichier

[élément(s)]

[faible / moyen / fort]

[1–4]

[limites/doutes]

Cohérence spatio-temporelle

[élément(s)]

[faible / moyen / fort]

[1–4]

[limites/doutes]

Signatures capteur

[élément(s)]

[faible / moyen / fort]

[1–4]

[limites/doutes]

Traces d’édition

[élément(s)]

[faible / moyen / fort]

[1–4]

[limites/doutes]

Explications prosaïques testées

[élément(s)]

[faible / moyen / fort]

[1–4]

[limites/doutes]

ANNEXE 6 — Manuel de codage (gabarit + exemple)

• Intitulé du critère et objectif (ce que l’on mesure).

• Définition opératoire (conditions minimales, observables).

• Échelle de notation (de −2 à +2) avec ancres décrites.

• Exemples frontières (cas limites).

• Arbre d’aide à la décision (3–5 nœuds).

• Erreurs fréquentes à éviter.

• Traçabilité : pièces utilisées, liens, horodatages.

Exemple — Critère « Cohérence inter-témoins » :

Note

Description d’ancrage

Exemple concret

+2

Récits concordants sur trame & détails cruciaux ; divergences minimes.

Trois témoins indépendants : mêmes horaires et positions.

+1

Trame concordante ; quelques divergences non déterminantes.

Détails secondaires varient, chronologie concorde.

0

Cohérence indécidable ou mixte.

Deux concordent, un diverge ; données insuffisantes.

−1

Divergences notables sur éléments centraux.

Incompatibilités distance/durée.

−2

Contradictions majeures et récurrentes.

Versions successives incohérentes ; contradictions sur le lieu.

• Q1 : Indépendance des témoins ? Si non → max 0.

• Q2 : Trame temporelle concordante ? Si non → −1 à −2.

• Q3 : Détails cruciaux concordants ? Si oui → +1 ; sinon → 0 à −1.

• Q4 : Contradictions récurrentes ? Si oui → −2.

ANNEXE 7 — Seuils & classes de décision (avec portes non compensatoires)

Cartographie des classes d’interprétation avec exigences minimales sur le pilier « Preuves ».

Classe

Total (T+P)

Exigence « Preuves »

Interprétation

Actions recommandées

Faible

< 40

—

Affaire insuffisamment étayée.

Clore ou collecter de nouvelles pièces de base.

Incertain

40–59

Preuves ≥ 20

Affaire ouverte mais lacunaire.

Prioriser analyses forensiques et indépendances des témoins.

Solide

60–74

Preuves ≥ 30

Affaire bien étayée, cohérente.

Audits externes ciblés ; rapport provisoire.

Fort

≥ 75

Preuves ≥ 40

Affaire très bien étayée.

Publication complète ; mise à disposition des données.

Règle : franchir un seuil seulement si (Total − marge) ≥ seuil et exigence « Preuves » satisfaite.

ANNEXE 8 — Panel de cas étalons pour calibration

Sélectionner 5–12 cas représentatifs pour tester et ajuster barèmes et seuils, et vérifier la stabilité inter-évaluateurs.

ID étalon

Type de cas

Brève description

Témoignages (réf.)

Preuves (réf.)

Total (réf.)

Classe (réf.)

Remarques

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

[à compléter]

• Inclure au moins : (A) témoignages forts / preuves faibles ; (B) inverse ; (C) médias audités indépendamment.

• Documenter les écarts observés et leurs causes ; ajuster les barèmes si nécessaire.

ANNEXE 9 — Fiche synthèse standard d’une affaire

Une page de synthèse à joindre à toute publication du score.

Rubrique

Contenu

Titre de l’affaire / ID

[à compléter]

Résumé en 5 lignes

[à compléter]

Contexte (date/lieu/conditions)

[à compléter]

Témoignages — sous-score

[à compléter]

Preuves — sous-score

[à compléter]

Total (± marge) et classe

[à compléter]

Indicateurs de qualité (κ, test–retest)

[à compléter]

Pièces principales (IDs et liens)

[à compléter]

Points forts déterminants

[à compléter]

Limites et doutes

[à compléter]

Actions recommandées (priorisées)

[à compléter]

Version de la grille / barèmes utilisés

[à compléter]

Acronyme

Définition

AHP/MAUT

Méthodes d’analyse multicritères pour pondérer et agréger des critères.

ELA

Error Level Analysis ; détection de zones de recompression anormales.

GRADE

Cadre de hiérarchisation des niveaux de preuve.

ICC

Intraclass Correlation Coefficient ; stabilité test–retest.

IC

Intervalle de confiance ; fourchette d’incertitude statistique.

κ (kappa)

Accord inter‑évaluateurs au‑delà du hasard (κ ≥ 0,70 visé).

PDCA

Plan–Do–Check–Act ; boucle d’amélioration continue.

PRNU/SPN

Empreintes de bruit de capteur pour authentifier une image.

ROC

Receiver Operating Characteristic ; choix de seuils (vrais/faux positifs).